باختصار

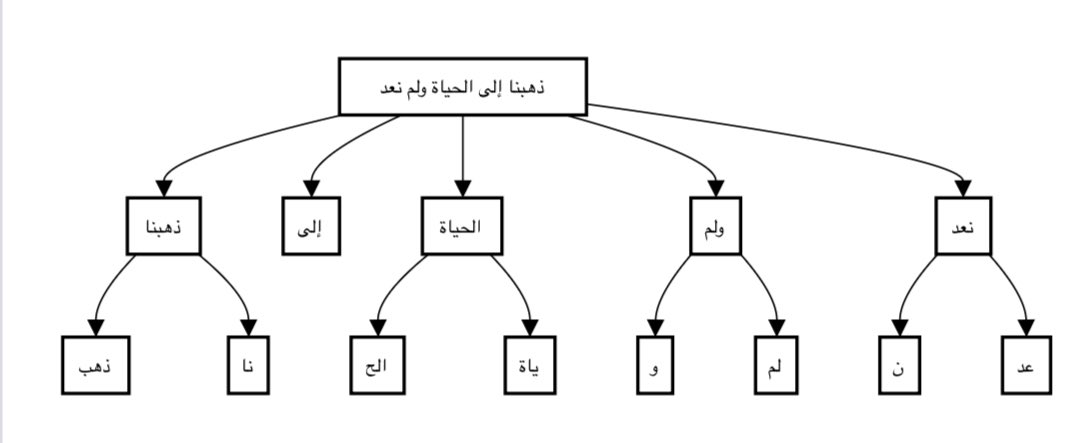

(ذهبنا إلى الحياة ولم نعد)

▫️GPT-4

يحتاج إلى تقسيم الجملة إلى 53 توكين، أي كل جزء صغير من الجملة (مثل “ذه” و”بنا” و”إلى”) يتم معالجته كوحدة مستقلة

▪️GPT-4o

يحتاج إلى تقسيم الجملة إلى 26 توكين فقط، أي كل جزء أكبر (مثل “ذهبنا” و”إلى” و”الحياة”) يتم معالجته كوحدة واحدة

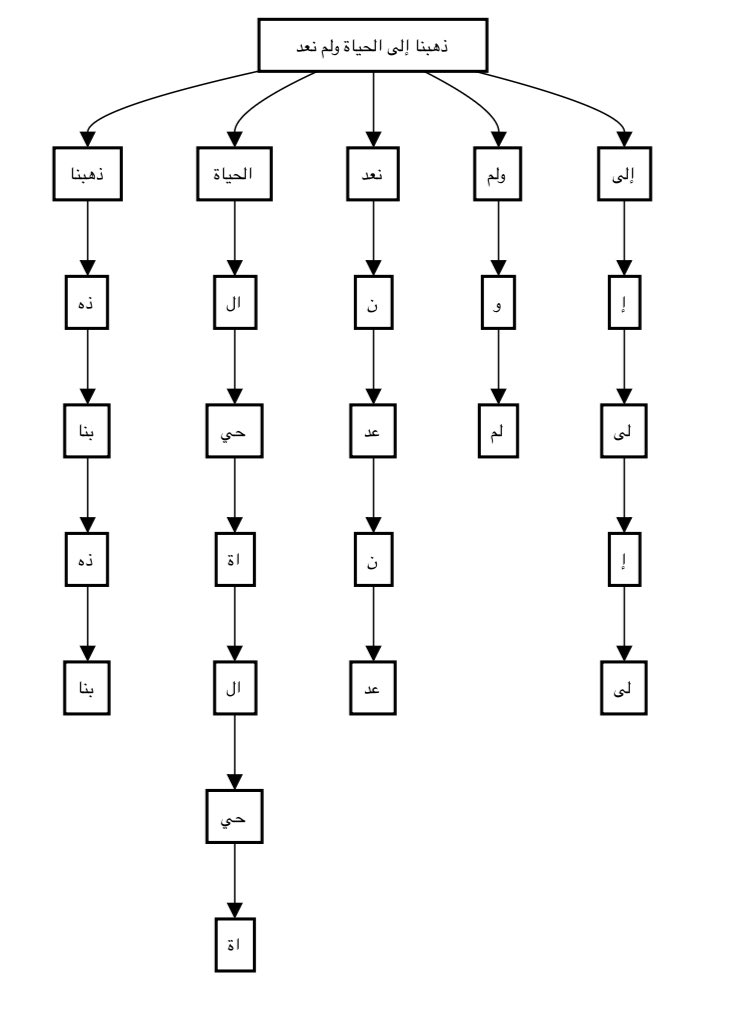

(ذهبنا إلى الحياة ولم نعد)

▫️GPT-4

يحتاج إلى تقسيم الجملة إلى 53 توكين، أي كل جزء صغير من الجملة (مثل “ذه” و”بنا” و”إلى”) يتم معالجته كوحدة مستقلة

▪️GPT-4o

يحتاج إلى تقسيم الجملة إلى 26 توكين فقط، أي كل جزء أكبر (مثل “ذهبنا” و”إلى” و”الحياة”) يتم معالجته كوحدة واحدة

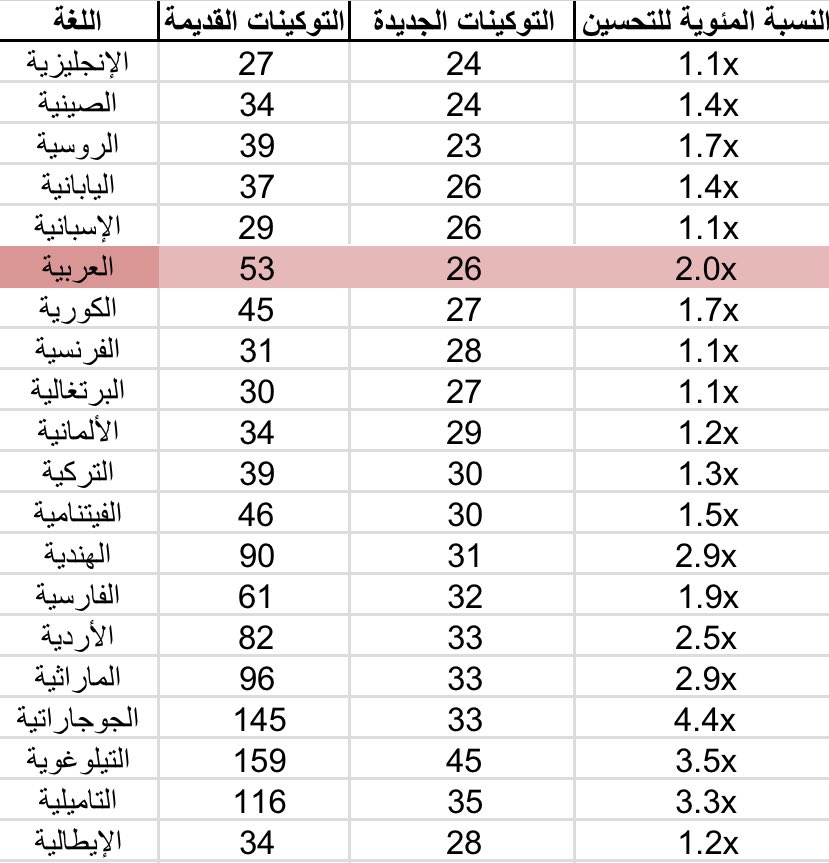

ماذا يعني ذلك؟

عندما تصبح عدد التوكينات أقل في النموذج، فإنه:

= يعالج النصوص بسرعة أكبر لأنه يتعامل مع عدد أقل من الأجزاء

=البيانات التي يحتاج لمعالجتها تصبح أقل، أي يقل استهلاك الموارد

=يفهم النص بشكل أفضل لأنه يتعامل مع أجزاء أكبر تحمل معنى أكثر

عندما تصبح عدد التوكينات أقل في النموذج، فإنه:

= يعالج النصوص بسرعة أكبر لأنه يتعامل مع عدد أقل من الأجزاء

=البيانات التي يحتاج لمعالجتها تصبح أقل، أي يقل استهلاك الموارد

=يفهم النص بشكل أفضل لأنه يتعامل مع أجزاء أكبر تحمل معنى أكثر

جاري تحميل الاقتراحات...