ساتحدث بعد قليل عن دراسة جديدة هزت مجتمع #الذكاء_الاصطناعي و #الاعمال على حد سواء حيث اثبتت ان برامجه ونماذجه قد تدمر نفسها بنفسها.

واطلق باحثون من جامعات #كامبريدج و #أكسفورد و تورنتو و إمبريال كوليج لندن على هذه الظاهرة اسم #انهيار_النموذج.

1️⃣

.

.

واطلق باحثون من جامعات #كامبريدج و #أكسفورد و تورنتو و إمبريال كوليج لندن على هذه الظاهرة اسم #انهيار_النموذج.

1️⃣

.

.

وهذه أخبارًا ليست جيدة لموثوقية نماذج #الذكاء_الاصطناعي وقابليتها للاستخدام.

إنها تحمل آثارًا بعيدة المدى للمنظمات والشركات التي تحاول الاستفادة من قدرات الأعمال الثورية التوليدية للذكاء الاصطناعي.

كما يؤكد على أهمية سيادة البيانات وعمليات الحوكمة الملائمة للمستقبل من حيث صلتها بعمليات التكامل المدعومة بالذكاء الاصطناعي عبر عمليات الشركة.

1️⃣

إنها تحمل آثارًا بعيدة المدى للمنظمات والشركات التي تحاول الاستفادة من قدرات الأعمال الثورية التوليدية للذكاء الاصطناعي.

كما يؤكد على أهمية سيادة البيانات وعمليات الحوكمة الملائمة للمستقبل من حيث صلتها بعمليات التكامل المدعومة بالذكاء الاصطناعي عبر عمليات الشركة.

1️⃣

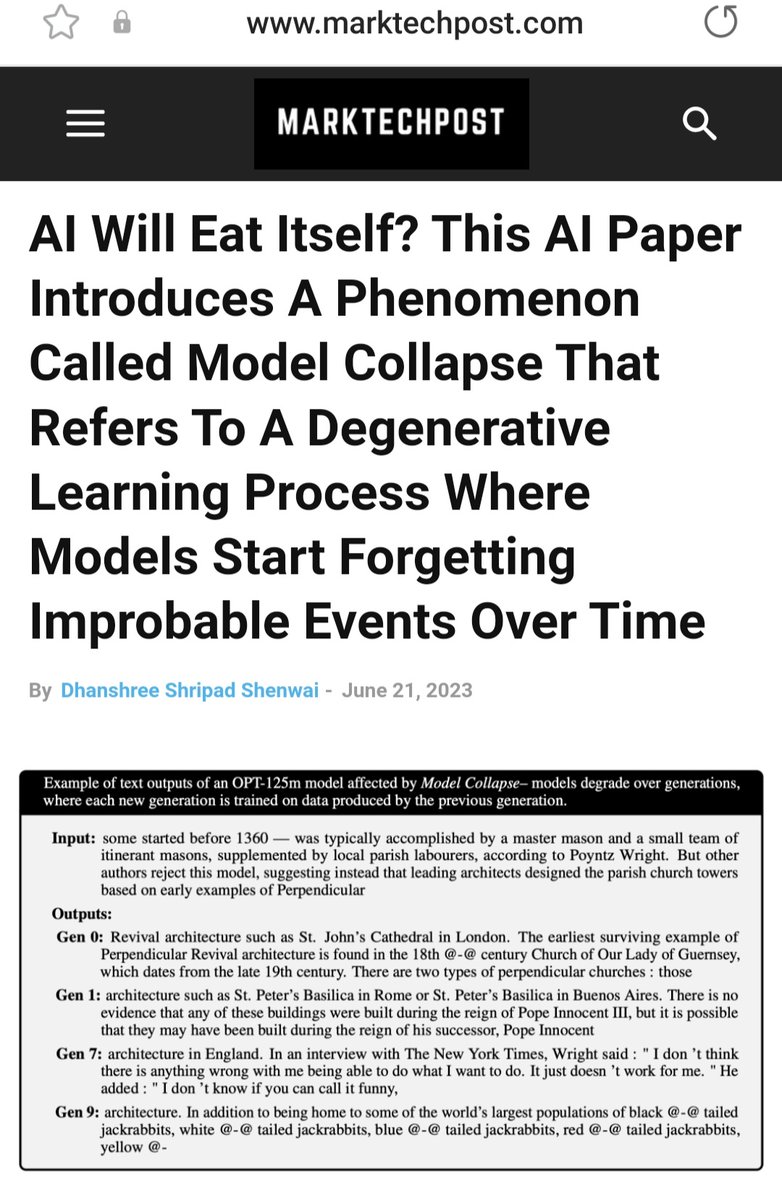

وكان عنوان الدراسة التي نشرها مجموعة من الباحثين الأكاديميين البارزين في الجامعات المذكورة:

"لعنة استدعاء البيانات الذاتي: التدريب على البيانات المتولدة يجعل النماذج تنساها"

وتوضح الدراسة:

أن المحتوى الذي تم إنشاؤه بواسطة نماذج #الذكاء_الاصطناعي المختلفة يتدهور تدريجياً ويفقد الوضوح عند التدريب المتتالي على بيانات التعلم التي تنتجها النماذج الأخرى.

ذكرت ايضا:

إن استخدام #LLM على نطاق واسع لنشر المحتوى على الإنترنت سيلوث جميع البيانات التي تستخدم لتدريبهم.

3️⃣

"لعنة استدعاء البيانات الذاتي: التدريب على البيانات المتولدة يجعل النماذج تنساها"

وتوضح الدراسة:

أن المحتوى الذي تم إنشاؤه بواسطة نماذج #الذكاء_الاصطناعي المختلفة يتدهور تدريجياً ويفقد الوضوح عند التدريب المتتالي على بيانات التعلم التي تنتجها النماذج الأخرى.

ذكرت ايضا:

إن استخدام #LLM على نطاق واسع لنشر المحتوى على الإنترنت سيلوث جميع البيانات التي تستخدم لتدريبهم.

3️⃣

ولتوضيح معنى ذلك:

نعلم جميعًا أن نماذج #الذكاء_الاصطناعي وأدواته مثل #ChatGPT و #Bard واشباهها تستخدم البيانات الموجودة على الانترنت للإجابة على أسئلتنا.

بمعنى انها تتغذى على محتوى الإنترنت الذي كتبه وجمعه الإنسان بما في ذلك مواقع Wikipedia و Getty و Scribd سواء من النصوص اوالصور اوالمحتويات الأخرى.

ونظرًا لأن المحتوى الذي يتم إنشاؤه بواسطة تلك النماذج والادوات يصبح أكثر انتشارًا ويتم إضافته إلى المجموعة الهائلة من بيانات التدريب، فهنا تتراكم الأخطاء وعدم الوضوح والحالات الغير منطقية.

وتكافح أنظمة الذكاء الاصطناعي اللاحقة للتمييز بين الحقيقة والخيال، حيث يفقد كل جيل لاحق تألقه الأصلي وينتقل إلى إنتاجا مربكا و أقل وضوحا ومن الجيل الذي يليه سينتج نفايات لا معنى لها وبالتالي سيدمر نفسه بنفسه.

4️⃣

نعلم جميعًا أن نماذج #الذكاء_الاصطناعي وأدواته مثل #ChatGPT و #Bard واشباهها تستخدم البيانات الموجودة على الانترنت للإجابة على أسئلتنا.

بمعنى انها تتغذى على محتوى الإنترنت الذي كتبه وجمعه الإنسان بما في ذلك مواقع Wikipedia و Getty و Scribd سواء من النصوص اوالصور اوالمحتويات الأخرى.

ونظرًا لأن المحتوى الذي يتم إنشاؤه بواسطة تلك النماذج والادوات يصبح أكثر انتشارًا ويتم إضافته إلى المجموعة الهائلة من بيانات التدريب، فهنا تتراكم الأخطاء وعدم الوضوح والحالات الغير منطقية.

وتكافح أنظمة الذكاء الاصطناعي اللاحقة للتمييز بين الحقيقة والخيال، حيث يفقد كل جيل لاحق تألقه الأصلي وينتقل إلى إنتاجا مربكا و أقل وضوحا ومن الجيل الذي يليه سينتج نفايات لا معنى لها وبالتالي سيدمر نفسه بنفسه.

4️⃣

ولشرح المسكلة من زاوية اخرى:

ان ظهور الإنترنت أحدث ثورة في الطريقة التي يمكن بها مشاركة المعلومات، وخلقت طرقًا جديدة للتواصل، مما سمح بتحليل النص وتعديله وظهوره من خلال منصات البحث والحلول الأخرى متعددة الطبقات.

الآن، #الذكاء_الاصطناعي #التوليدي، (الذي سمي كذلك بسبب قدرته على توليد وإنتاج المحتوى وإنشاءه بشكل مستقل)، يقوم ببناء طبقة معلومات أخرى فوق طبقة المشهد عبر الإنترنت.

يعني ينسخ فوق النسخ، وكما نعلم ان عملية نسخ النسخ المتكرره تزداد سوءًا.

وإذا استمرت بيانات التدريب المستخدمة لتشغيل نماذج ومحركات الذكاء الاصطناعي التوليدية المستقبلية، بما في ذلك نماذج اللغات الكبيرة (LLMs) ونماذج المزيج الغاوسي (GMMs) والمشفرات التلقائية المتنوعة (VAE) ، ولم يتم مسحها من الإنترنت ، سوف يتم تدريب تلك النماذجحتمًا على المحتوى الذي تم نسخه بواسطة أدوات الذكاء الاصطناعي التوليدية الحالية.

وهكذا تتكرر ماساة تشويه المعلومات وتصبح بدون معنى وبدون فائدة.

5️⃣

ان ظهور الإنترنت أحدث ثورة في الطريقة التي يمكن بها مشاركة المعلومات، وخلقت طرقًا جديدة للتواصل، مما سمح بتحليل النص وتعديله وظهوره من خلال منصات البحث والحلول الأخرى متعددة الطبقات.

الآن، #الذكاء_الاصطناعي #التوليدي، (الذي سمي كذلك بسبب قدرته على توليد وإنتاج المحتوى وإنشاءه بشكل مستقل)، يقوم ببناء طبقة معلومات أخرى فوق طبقة المشهد عبر الإنترنت.

يعني ينسخ فوق النسخ، وكما نعلم ان عملية نسخ النسخ المتكرره تزداد سوءًا.

وإذا استمرت بيانات التدريب المستخدمة لتشغيل نماذج ومحركات الذكاء الاصطناعي التوليدية المستقبلية، بما في ذلك نماذج اللغات الكبيرة (LLMs) ونماذج المزيج الغاوسي (GMMs) والمشفرات التلقائية المتنوعة (VAE) ، ولم يتم مسحها من الإنترنت ، سوف يتم تدريب تلك النماذجحتمًا على المحتوى الذي تم نسخه بواسطة أدوات الذكاء الاصطناعي التوليدية الحالية.

وهكذا تتكرر ماساة تشويه المعلومات وتصبح بدون معنى وبدون فائدة.

5️⃣

ويقول الباحثون في هذه الدراسة:

ننظر في ما قد يحمله المستقبل. وماذا سيحدث لـ GPT- {n} بمجرد أن تقذف LLM الكثير من انتاجها على الإنترنت؟

وقد وجدنا أن استخدام المحتوى الناتج عن النموذج في التدريب يسبب عيوبًا لا رجعة فيها في النماذج الناتجة، حيث اختفي المحتوى الأصلي وبقى المحتوى الهجين الغير مفهوم والغير منطقي والذي تكرر غسله في تلك النماذج.

6️⃣

ننظر في ما قد يحمله المستقبل. وماذا سيحدث لـ GPT- {n} بمجرد أن تقذف LLM الكثير من انتاجها على الإنترنت؟

وقد وجدنا أن استخدام المحتوى الناتج عن النموذج في التدريب يسبب عيوبًا لا رجعة فيها في النماذج الناتجة، حيث اختفي المحتوى الأصلي وبقى المحتوى الهجين الغير مفهوم والغير منطقي والذي تكرر غسله في تلك النماذج.

6️⃣

ويختتم الباحثون بالحديث عن التأثيرات الأكبر لانهيار النموذج. و أنه يجب أخذها على محمل الجد.

🔅في الواقع ، فإن قيمة البيانات الخام على الانترنت ستكون ذات قيمة متزايدة. وان هناك حاجة ملحة إلى تمييزها عن البيانات الأخرى المتولده اتوماتيكيا عن نماذج #الذكاء_الاصطناعي والتي تسمم بيانات الانترنا.

🔅وفي ظل وجود المحتوى المشوه الذي تم توليده اتوماتيكيا بواسطة #LLM ونماذجها وخطر زحفه إلى الإنترنت، فيجب التنسيق على مستوى المجتمع حول نهج واحد لضمان أن جميع الأطراف المشاركة في تطوير ونشر LLM يتواصلون ويشاركون البيانات اللازمة لتسوية مشاكل المصدر.

7️⃣

🔅في الواقع ، فإن قيمة البيانات الخام على الانترنت ستكون ذات قيمة متزايدة. وان هناك حاجة ملحة إلى تمييزها عن البيانات الأخرى المتولده اتوماتيكيا عن نماذج #الذكاء_الاصطناعي والتي تسمم بيانات الانترنا.

🔅وفي ظل وجود المحتوى المشوه الذي تم توليده اتوماتيكيا بواسطة #LLM ونماذجها وخطر زحفه إلى الإنترنت، فيجب التنسيق على مستوى المجتمع حول نهج واحد لضمان أن جميع الأطراف المشاركة في تطوير ونشر LLM يتواصلون ويشاركون البيانات اللازمة لتسوية مشاكل المصدر.

7️⃣

واضاف الباحثين في استنتاجاتهم:

ان هجمات تسميم البيانات طويلة المدى ليست جديدة. و رأيناها على نماذج اللغة البشرية في تضليل الشبكات الاجتماعية وخوارزميات البحث وتشويه الصور.

وقد أدى التأثير السلبي لهجمات التسمم هذه على نتائج البحث إلى تغييرات في خوارزميات البحث: على سبيل المثال ، خفضت Google إصدارها للمقالات العشوائية وركزت بشكل أكبر على المحتوى الذي تنتجه مصادر جديرة بالثقة.

ما يختلف مع ظهور نماذج #الذكاء_الاصطناعي التي تنتجها LLM هو الحجم الذي يمكن أن يحدث به مثل هذا التسمم بمجرد أن يتم تشغيلها تلقائيًا.

و نوضح أن التدريب على عينات من نموذج توليدي آخر يمكن أن يؤدي إلى تحول في التوزيع، والذي يؤدي بمرور الوقت إلى انهيار النموذج. وهذا بدوره يؤدي إلى إساءة فهم النموذج لمهمة التعلم الأساسية.

من غير الواضح كيف يمكن تتبع المحتوى الذي تم إنشاؤه بواسطة LLM على نطاق واسع. لكن أحد الخيارات هو ماذكرناه سابقا وهو التنسيق على مستوى المجتمع لضمان أن الأطراف المختلفة المشاركة في إنشاء ونشر LLM تشارك المعلومات اللازمة لحل مسائل المصدر. خلاف ذلك ، قد يصبح من الصعب بشكل متزايد تدريب إصدارات أحدث من LLM دون الوصول إلى البيانات التي زحفت الى الإنترنت قبل التبني الشامل لنماذج الذكاء الاصطناعي أو الوصول المباشر إلى البيانات التي تم إنشاؤها بواسطة البشر على نطاق واسع.

8️⃣

ان هجمات تسميم البيانات طويلة المدى ليست جديدة. و رأيناها على نماذج اللغة البشرية في تضليل الشبكات الاجتماعية وخوارزميات البحث وتشويه الصور.

وقد أدى التأثير السلبي لهجمات التسمم هذه على نتائج البحث إلى تغييرات في خوارزميات البحث: على سبيل المثال ، خفضت Google إصدارها للمقالات العشوائية وركزت بشكل أكبر على المحتوى الذي تنتجه مصادر جديرة بالثقة.

ما يختلف مع ظهور نماذج #الذكاء_الاصطناعي التي تنتجها LLM هو الحجم الذي يمكن أن يحدث به مثل هذا التسمم بمجرد أن يتم تشغيلها تلقائيًا.

و نوضح أن التدريب على عينات من نموذج توليدي آخر يمكن أن يؤدي إلى تحول في التوزيع، والذي يؤدي بمرور الوقت إلى انهيار النموذج. وهذا بدوره يؤدي إلى إساءة فهم النموذج لمهمة التعلم الأساسية.

من غير الواضح كيف يمكن تتبع المحتوى الذي تم إنشاؤه بواسطة LLM على نطاق واسع. لكن أحد الخيارات هو ماذكرناه سابقا وهو التنسيق على مستوى المجتمع لضمان أن الأطراف المختلفة المشاركة في إنشاء ونشر LLM تشارك المعلومات اللازمة لحل مسائل المصدر. خلاف ذلك ، قد يصبح من الصعب بشكل متزايد تدريب إصدارات أحدث من LLM دون الوصول إلى البيانات التي زحفت الى الإنترنت قبل التبني الشامل لنماذج الذكاء الاصطناعي أو الوصول المباشر إلى البيانات التي تم إنشاؤها بواسطة البشر على نطاق واسع.

8️⃣

المصادر 👇

⭕️ رابط The Atlantic

theatlantic.com

⭕️ رابط Arixiv

arxiv.org

⭕️ رابط pdf الدراسة

arxiv.org

9️⃣

.

.

.

⭕️ رابط The Atlantic

theatlantic.com

⭕️ رابط Arixiv

arxiv.org

⭕️ رابط pdf الدراسة

arxiv.org

9️⃣

.

.

.

جاري تحميل الاقتراحات...