Primero, el link: Planning for AGI and beyond

openai.com

Y ahora, durante los próximos minutos, mientras desayuno, os lo iré desgranando. Estoy tan emocionado que me tiemblan las manos.

openai.com

Y ahora, durante los próximos minutos, mientras desayuno, os lo iré desgranando. Estoy tan emocionado que me tiemblan las manos.

Primero, comienzan por lo importante: su misión y valores.

😇 Misión: asegurar que las AGIs (sistemas de IA que en términos generales serán más inteligentes que los humanos), beneficien a la humanidad... cuando surjan.

Y enlazan a sus valores: openai.com

😇 Misión: asegurar que las AGIs (sistemas de IA que en términos generales serán más inteligentes que los humanos), beneficien a la humanidad... cuando surjan.

Y enlazan a sus valores: openai.com

Yo aquí lo primero que he sentido, además de emoción, ha sido miedo. Los riesgos potenciales son tremendos.

¿Cuál será el marco ético moral de una entidad que es 2x, 10x, 100x.... 10000000x veces más inteligente que nosotros?

¿Le importaremos lo más mínimo?

¿Cuál será el marco ético moral de una entidad que es 2x, 10x, 100x.... 10000000x veces más inteligente que nosotros?

¿Le importaremos lo más mínimo?

A esta altura del artículo, la mayoría hemos saltado haciendo scroll hacia abajo en el artículo para ver si... ¿estarán dando alguna indicación técnica de lo que tienen en mente?

Pero no. El artículo es más bien una declaración de principios.

Lógicamente no sueltan ni un detalle sobre el roadmap técnico que puedan tener. Sería el roadmap más codiciado y potencialmente más peligroso que haya existido jamás... si acaso comparable al Proyecto Manhattan.

Lógicamente no sueltan ni un detalle sobre el roadmap técnico que puedan tener. Sería el roadmap más codiciado y potencialmente más peligroso que haya existido jamás... si acaso comparable al Proyecto Manhattan.

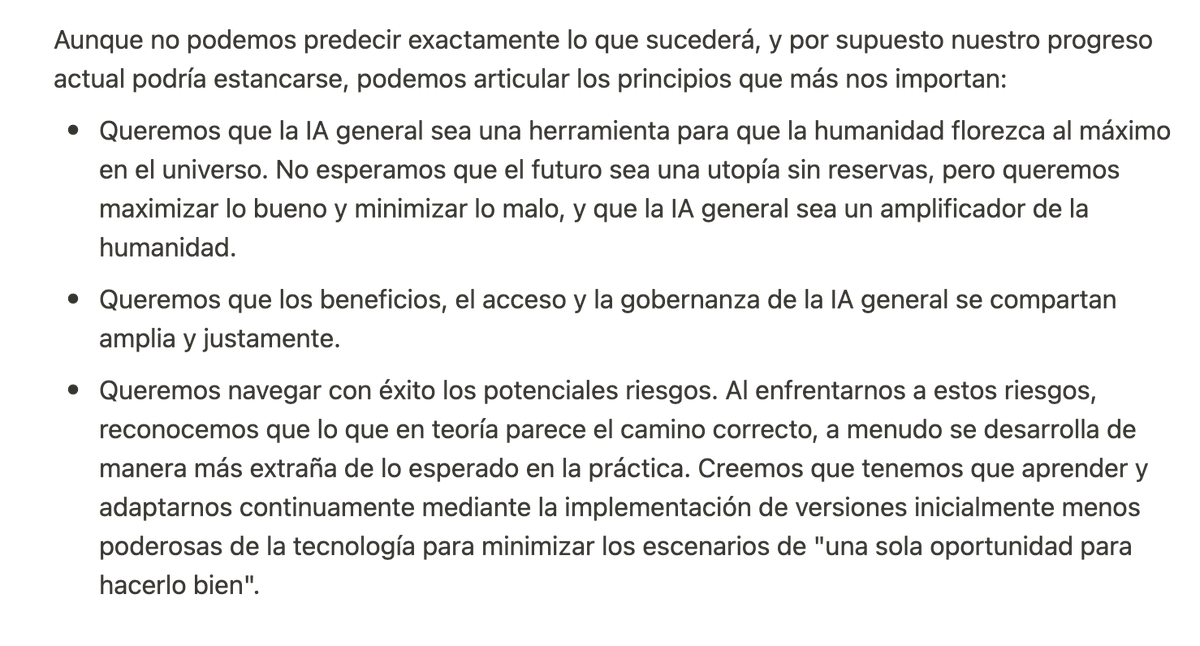

Y luego, divide el resto en "El corto plazo" vs "El largo plazo".

En el corto plazo, consideran un "go fast and break things" en el que continuamente querrán ir mostrando la tecnología aunque sea imperfecta para que se pueda ir asimilando de manera progresiva.

En el corto plazo, consideran un "go fast and break things" en el que continuamente querrán ir mostrando la tecnología aunque sea imperfecta para que se pueda ir asimilando de manera progresiva.

Para mí esto es un pensamiento... como mínimo ingenuo. Es la caja de pandora... ¿cómo vas a controlar algo que es más inteligente, mucho más, que tú mismo?

Y por si no tuviera ya suficiente miedo en el cuerpo, enlazan aquí: cold-takes.com

Y por si no tuviera ya suficiente miedo en el cuerpo, enlazan aquí: cold-takes.com

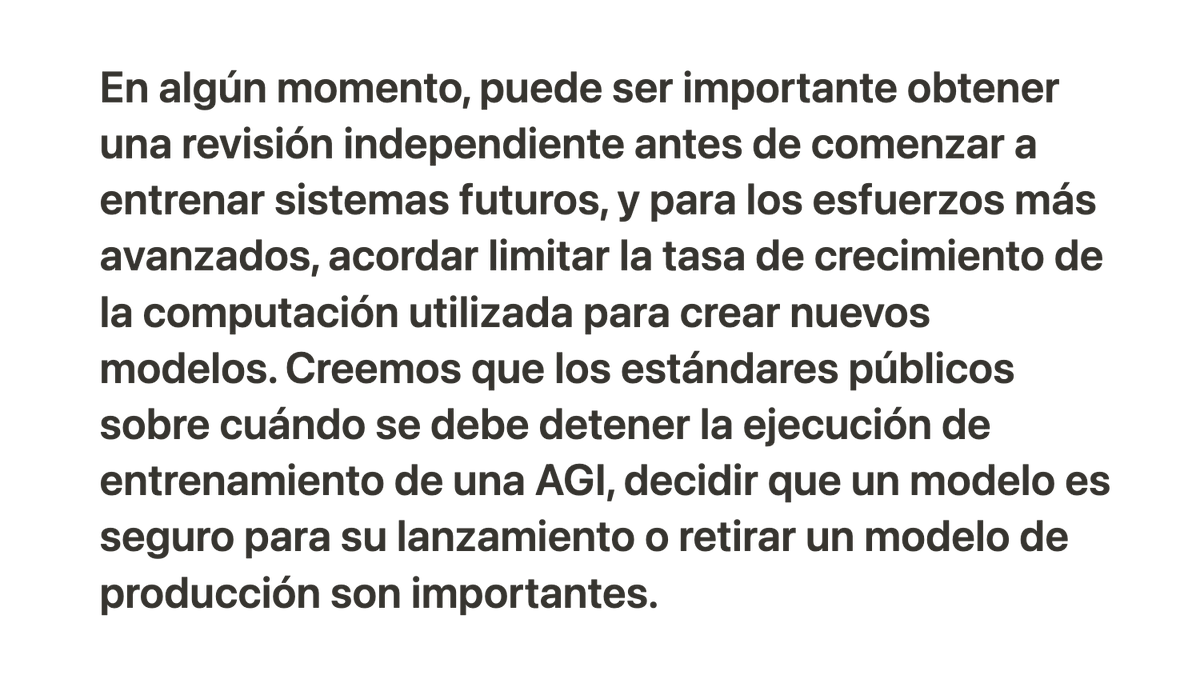

A continuación hablan de un concepto del que oiremos hablar MUCHO en los próximos años:

"Alineación de IAs: alinear la inteligencia artificial general (AGI) con los valores humanos, para que sigan la intención humana".

openai.com

"Alineación de IAs: alinear la inteligencia artificial general (AGI) con los valores humanos, para que sigan la intención humana".

openai.com

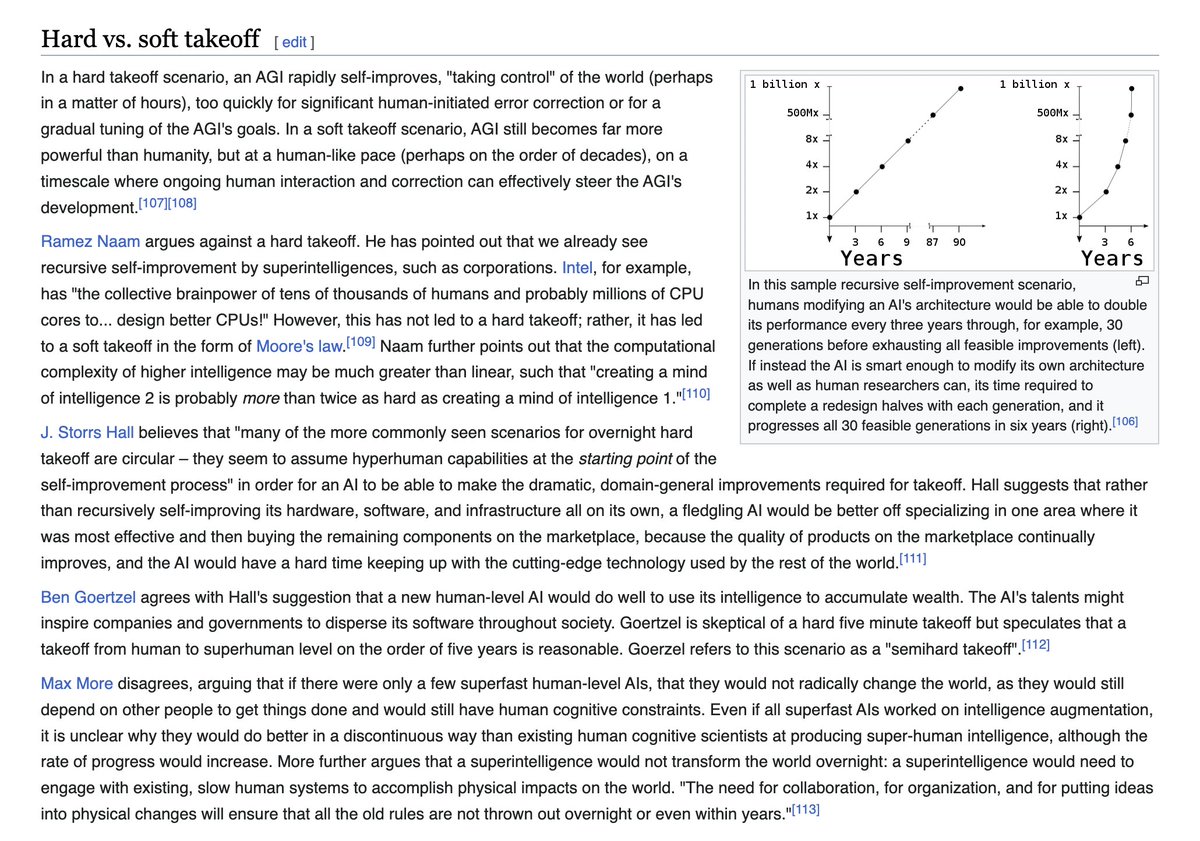

Una de cal y una de arena: también señalan los enormes riesgos que una "IA desalineada" tendría para la humanidad.

Y enlazan aquí: en.wikipedia.org

Me recuerda el tema a las novelas de Arthur C. Clarke, Iain Banks, Vernor Vinge, etc.

Y enlazan aquí: en.wikipedia.org

Me recuerda el tema a las novelas de Arthur C. Clarke, Iain Banks, Vernor Vinge, etc.

"Somos buenos, confiad en nosotros".

Una de las cosas que más se les ha criticado a OpenAI fue su decisión de dejar de ser una asociación sin ánimo de lucro (diviéndose en dos sociedades, una de ellas con ánimo de lucro). Más detalles aquí: analyticsindiamag.com

Una de las cosas que más se les ha criticado a OpenAI fue su decisión de dejar de ser una asociación sin ánimo de lucro (diviéndose en dos sociedades, una de ellas con ánimo de lucro). Más detalles aquí: analyticsindiamag.com

Como veis, según ellos, eso no añadiría riesgo a la ya arriesgada misión de intentar crear una AGI, es decir, aseguran que sus motivaciones económicas no tendrán prioridad sobre la seguridad.

Voy sesgado... siempre he sido algo pesimista al pensar en entidades superiores a nosotros... soy más proclive a pensar en conceptos a lo "Bosque oscuro" 😅

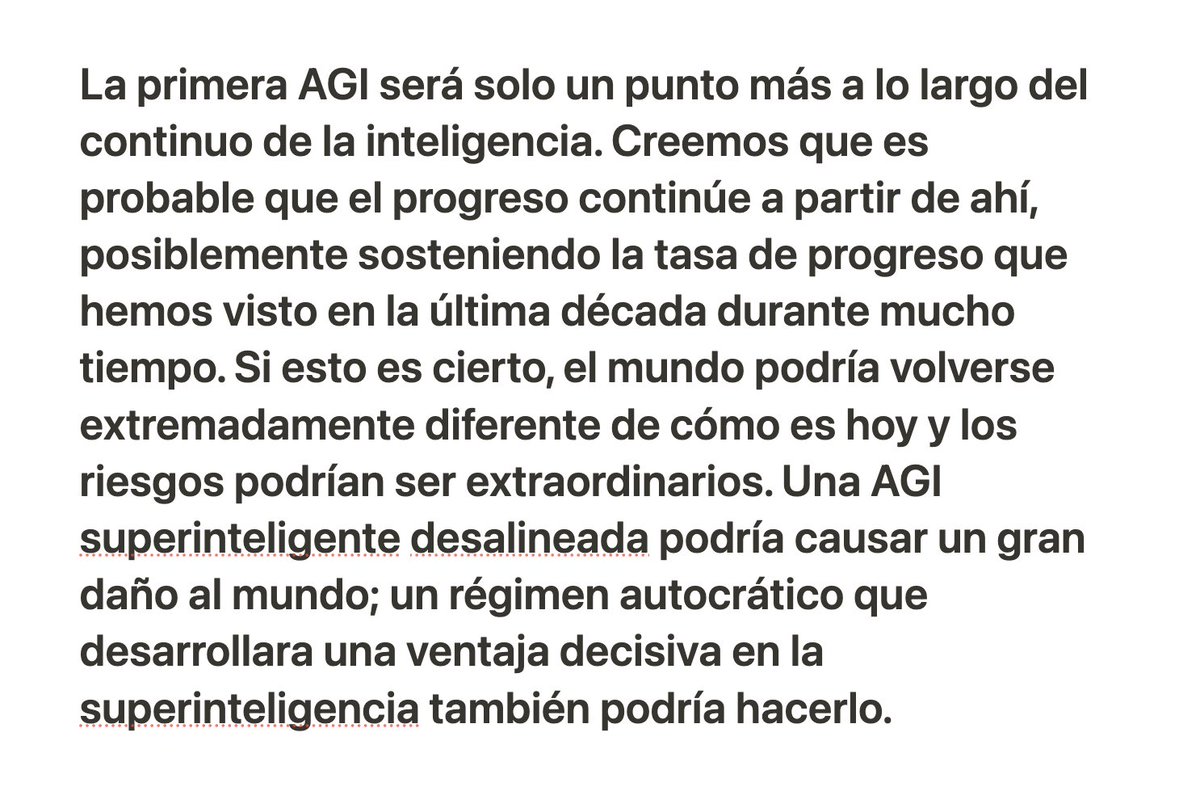

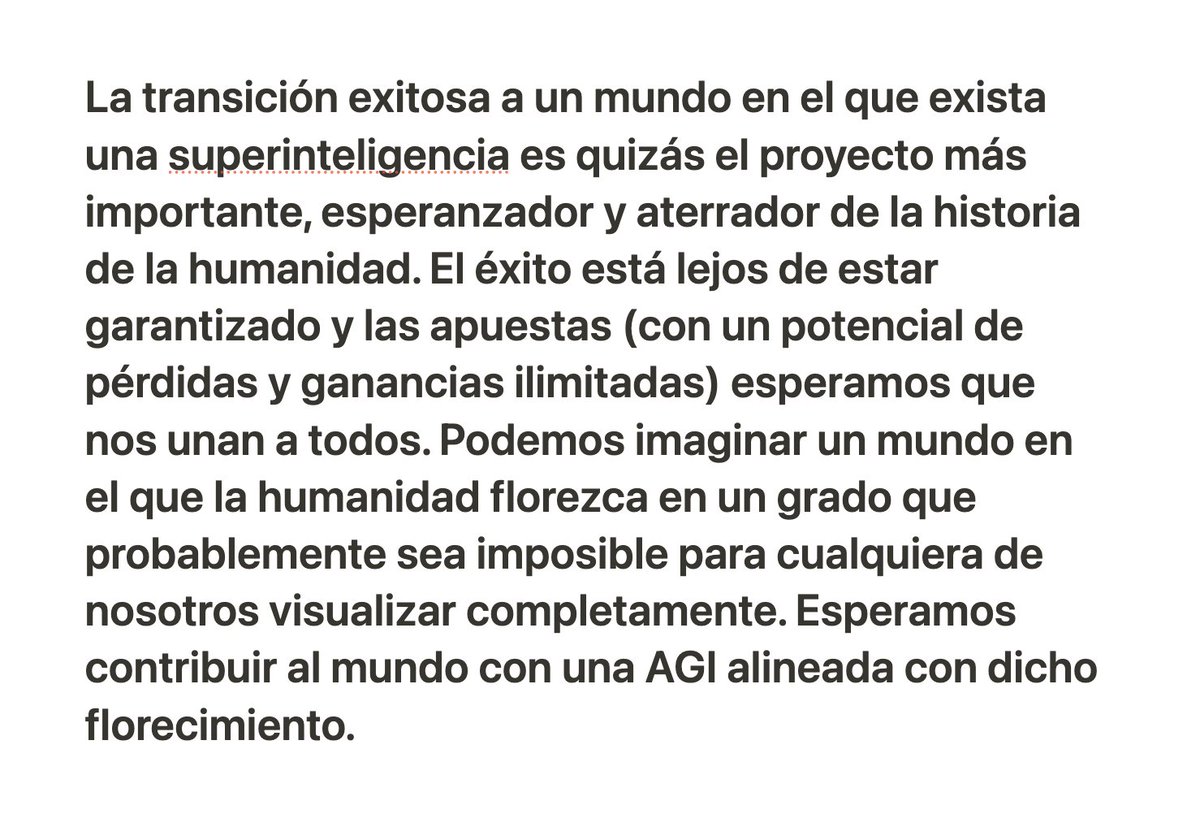

Por último hablan del largo plazo. Y son breves, dado que lógicamente si ya es difícil intentar predecir el futuro a corto plazo, imagínate a largo plazo y en algo tan cambiante.

Hablan también del impacto que tendrá la IA en la ciencia. Y cómo quizás habría que hacer esfuerzos, agárrate, para que la transición sea lo más suave posible.

También lo creo... y dudo que vaya a a ser suave.

No es un concepto nuevo este: en.wikipedia.org

También lo creo... y dudo que vaya a a ser suave.

No es un concepto nuevo este: en.wikipedia.org

Es ciencia ficción (hoy) pero tras el punto de singularidad... cualquier escenario que queramos imaginar es potencialmente posible.

Una IA que tuviera una comprensión física mucho mayor que la nuestra, podría tener un control absoluto sobre la materia que la rodease.

Una IA que tuviera una comprensión física mucho mayor que la nuestra, podría tener un control absoluto sobre la materia que la rodease.

Si te ha gustado y quieres que las AGIs post-singularidad sean benévolas contigo, un RT al primer tweet del hilo y suscribirte a mi newsletter harán que el Basilisco de Roko 🐲 te perdone la vida cuando cobre consciencia de sí mismo 😂🖖

javilop.substack.com

javilop.substack.com

جاري تحميل الاقتراحات...