في الأيام الماضية #ChatGPT أدهش العالم بسهولة التخاطب معه كذكاء اصطناعي وبدقة وتنوع المعلومات اللي يقدمها. حبيت آخذ نظرة عليه، ما هو من وجهة نظر المستخدم لكن من وجهة نظر المبرمج.

من الطرق اللي أحب التعلم من خلالها هي إني أحاول أشرح المعلومة لنفسي. ولذلك راح أكتب هذا الثريد:

👇

من الطرق اللي أحب التعلم من خلالها هي إني أحاول أشرح المعلومة لنفسي. ولذلك راح أكتب هذا الثريد:

👇

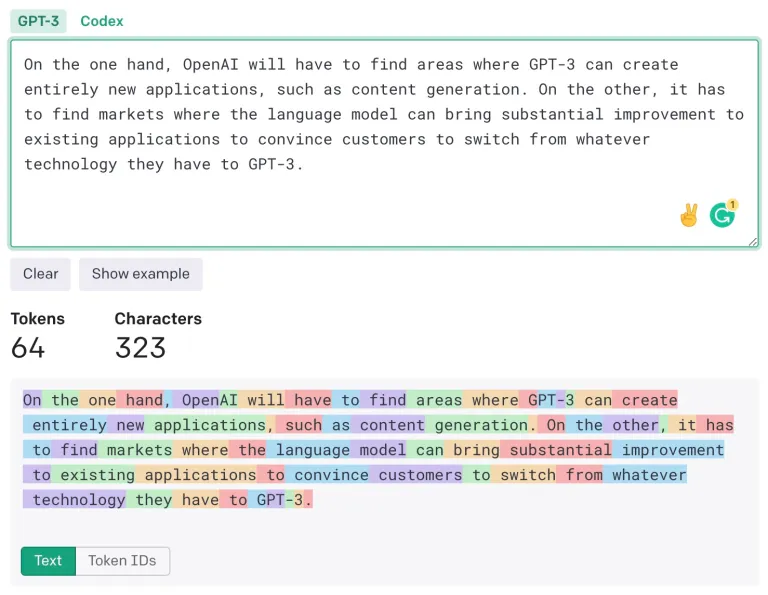

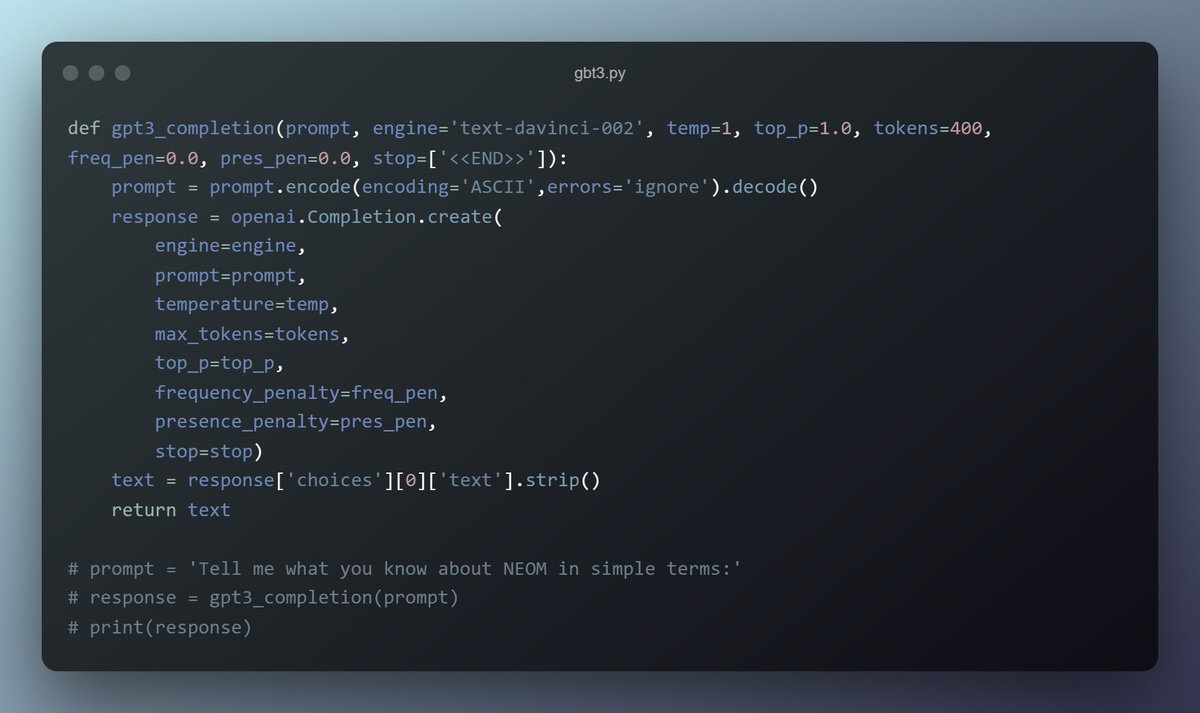

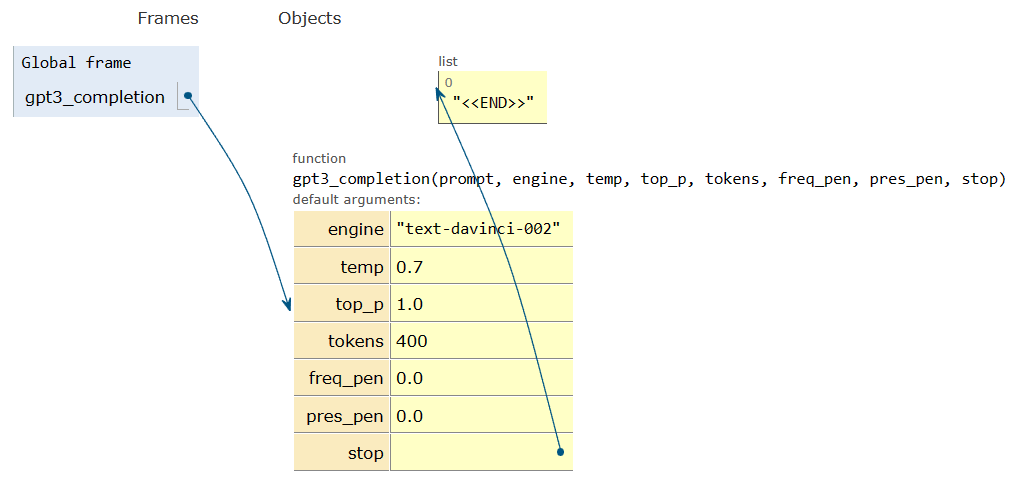

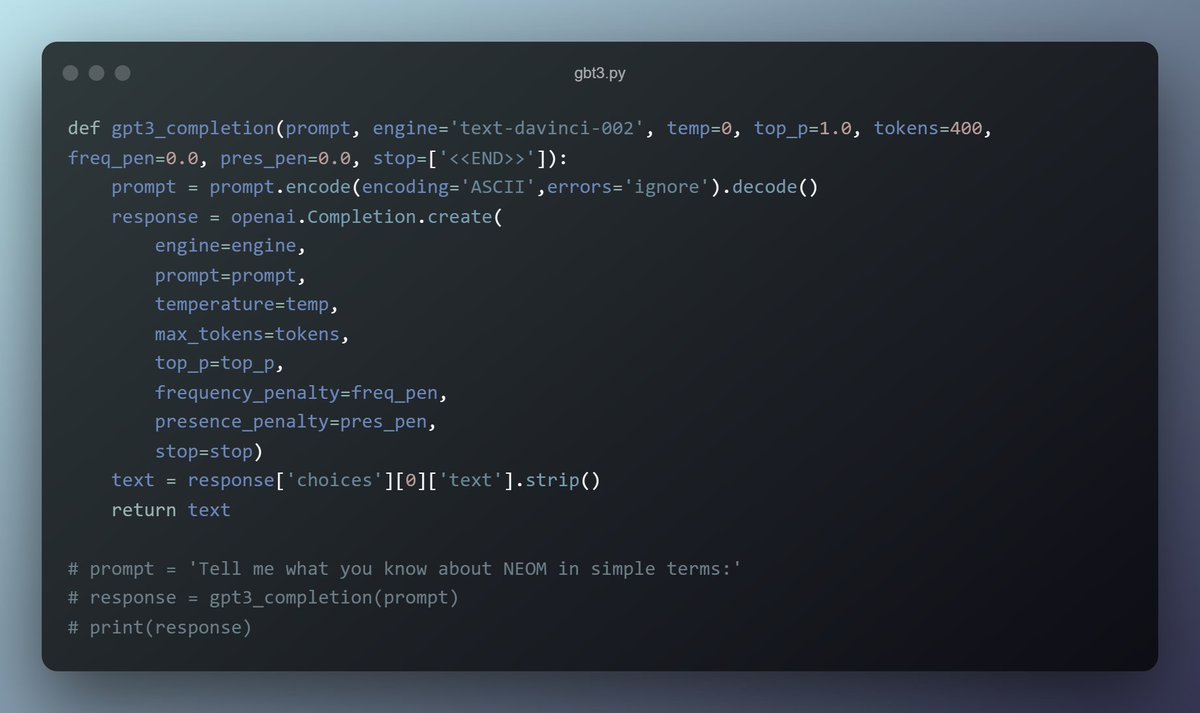

الـ argument الثانية هي max_tokens وهي مهمة حتى تتحكم بعدد التوكنز اللي يستعملها المودل ببناء الكومبليشن. كل ما زاد عدد التوكنز كل ما تشتت المودل في ايجاد الاجابة الأمثل. اللي فهمته انه المفروض انها ما تأثر كثير لما يكون الـ prompt قصير، بس تأثيرها يكبر كل ما كان الـ prompt أطول.

بعدها عندنا top_p وهذي فهمها احتاج مني شوية فهلوة :)

هي متعلقة بالـ probability distribution ومثل الـ temperature تاخذ من 0 الى 1. والرقم هذا يشكل النسبة المئوية من التوكنز اللي راح يتم أخذها بعين الاعتبار. لو حطيناه 0.5 معناه راح ياخذ التوكنز الـ 50% الأعلى ويغفل البقية.

هي متعلقة بالـ probability distribution ومثل الـ temperature تاخذ من 0 الى 1. والرقم هذا يشكل النسبة المئوية من التوكنز اللي راح يتم أخذها بعين الاعتبار. لو حطيناه 0.5 معناه راح ياخذ التوكنز الـ 50% الأعلى ويغفل البقية.

آخر ثنتين هم Frequency Penalty and Presence Penalty والفرق بينهم إن الأولى ترفع من أهمية التوكن بالنظر لعدد مرات تكراره من قبل، أما الثانية تقلل من أهمية التوكن إذا سبق وتكرر. التوازن بين الثنتين من المفترض إنه يخلق لك رد أفضل.

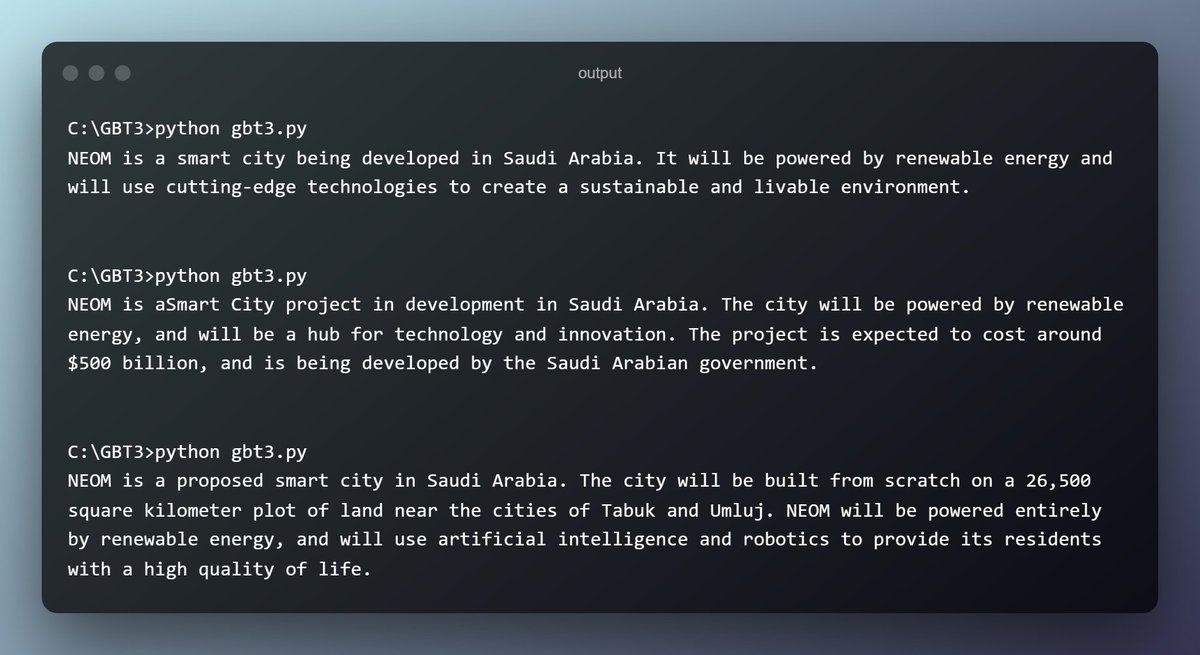

الخطوات اللي أحتاج أسويها في المضي قُدماً من هنا:

- النظر في إمكانية صنع واجهة مستخدم مبنية على أي شي غير Azure (الصفحة الحالية لـ ChatGBT مبنية باستعماله).

- طريقة تدريب الموديل على dataset خاصة (المودل يسمح بالـ Fine-tuning).

- النظر في إمكانية صنع واجهة مستخدم مبنية على أي شي غير Azure (الصفحة الحالية لـ ChatGBT مبنية باستعماله).

- طريقة تدريب الموديل على dataset خاصة (المودل يسمح بالـ Fine-tuning).

جاري تحميل الاقتراحات...