وبالنسبة للناس المحترمة راح نوضح الكلام بخصوص كيفية عمل المطابقة للصور الإباحية في الأجهزة بميزة CSAM:

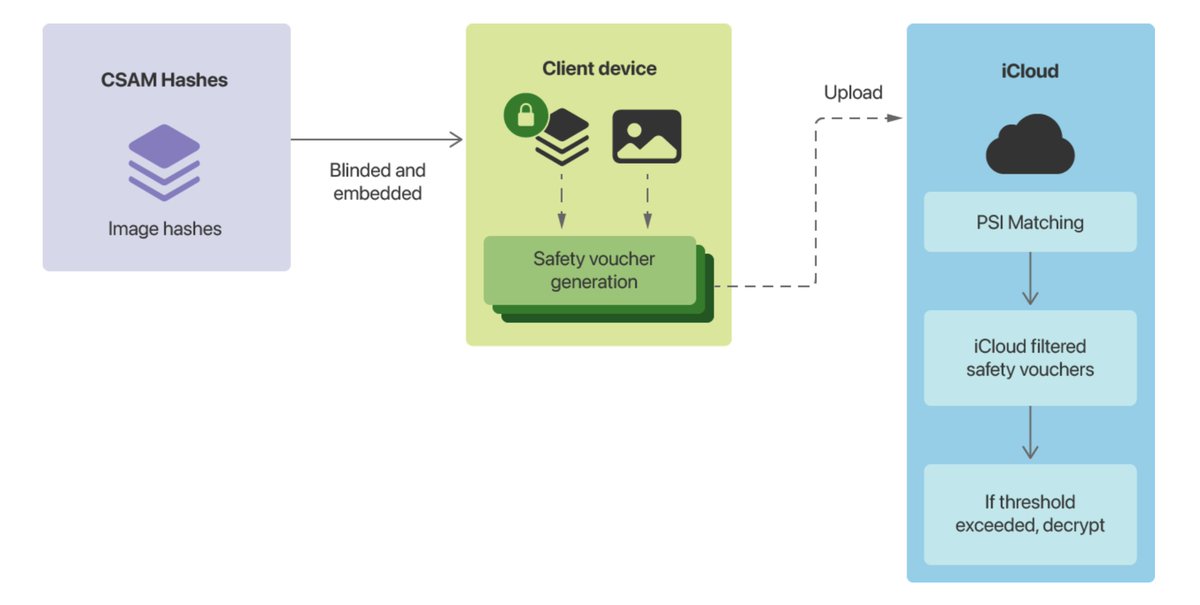

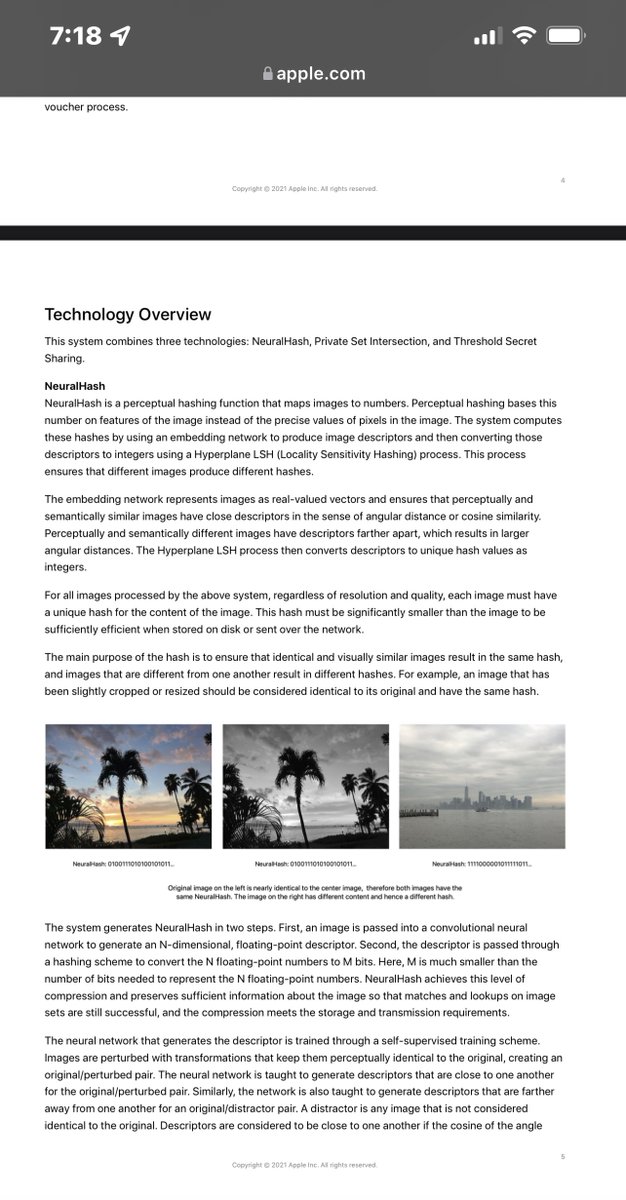

كل جهاز بنظام iOS 15 و iPadOS 15 سيكون منضمن مجموعة من قواعد البيانات التي تسمى NeuralHash هي عبارة عن لوغارثمات لمطابقة التعاريف للصور من منظمة NCMEC مع الصور في المكتبة.

كل جهاز بنظام iOS 15 و iPadOS 15 سيكون منضمن مجموعة من قواعد البيانات التي تسمى NeuralHash هي عبارة عن لوغارثمات لمطابقة التعاريف للصور من منظمة NCMEC مع الصور في المكتبة.

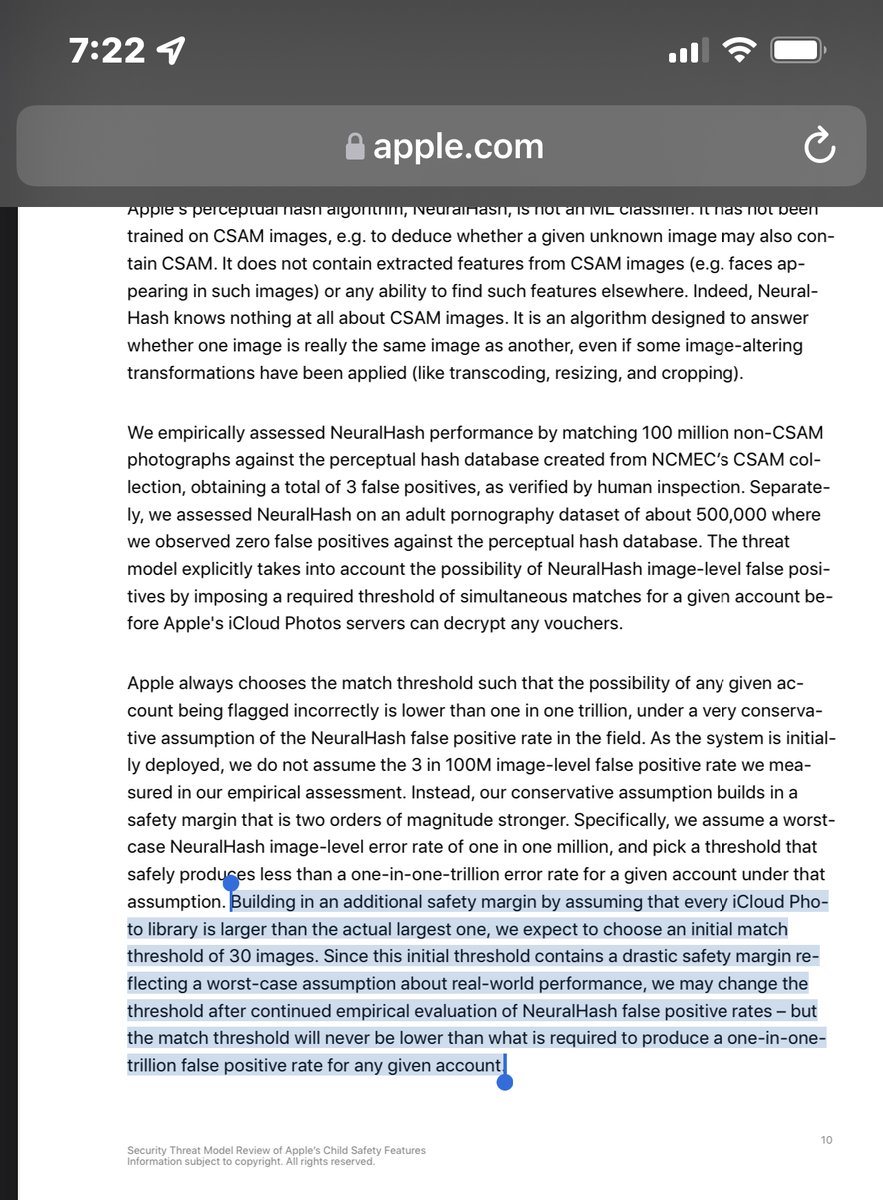

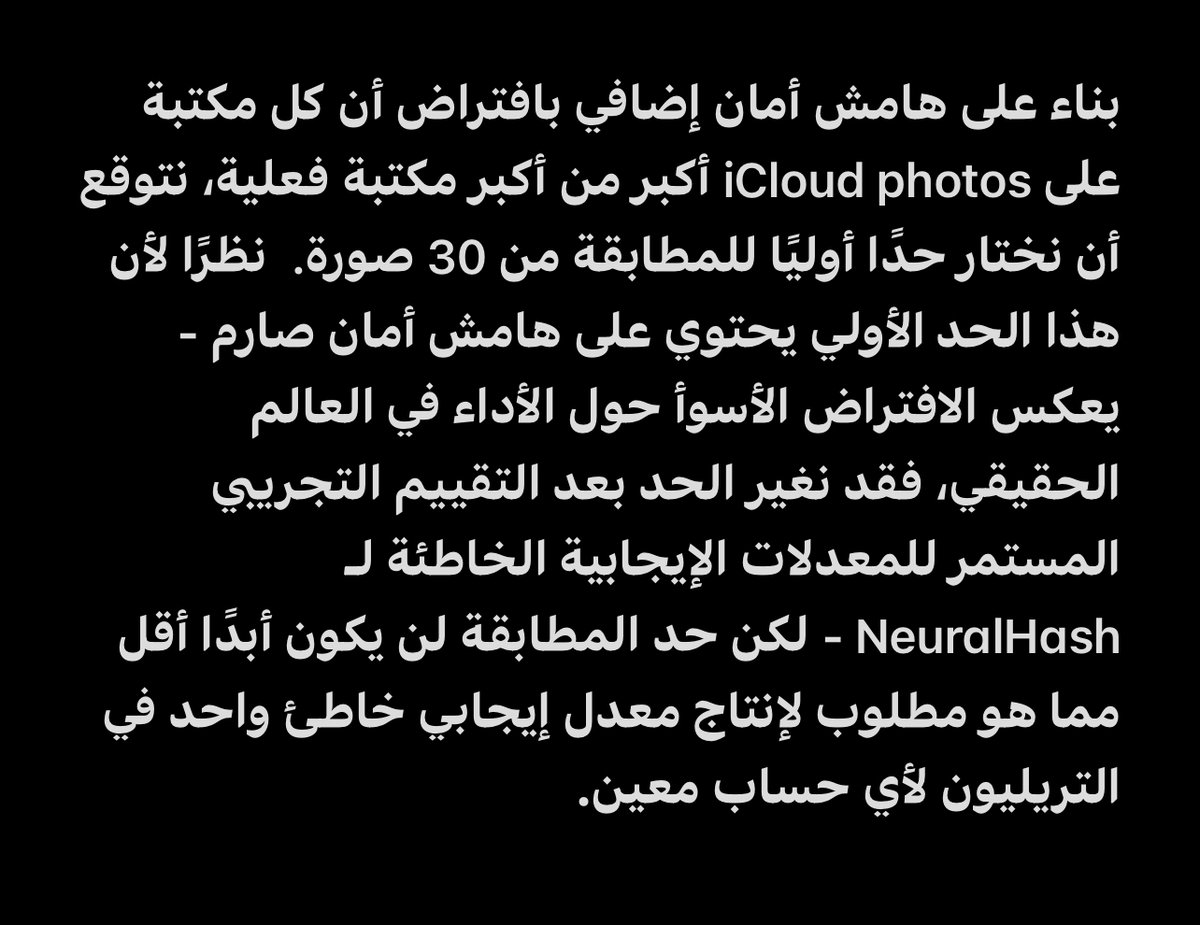

بمعنى أن الحد الأولي للإنتقال للخطوة التالية وهي فك التشفير عن الصور ومعاينتها يدويًا من آبل تتم بعد مطابقة 30 صورة أو أكثر وهذا الشيء قابل للتغيير.

ختامًا هذه مقابلة لغريك فيديريكي يتحدث بها عن عمل الخدمة وكيف أنها تختلف عن بقية الشركات التي تقوم بمسح جميع الصور في السحابة الخاصة بها بعكس هذه الخدمة.

youtu.be

youtu.be

جاري تحميل الاقتراحات...