الذكاء الإصطناعي و تحديداً المجال اللغوي NLP خطا خطوة واسعة مع GPT-3 . هناك الكثير من المقالات عنه كلاً بفهمه و بسبب أن امكانية تجربته محدودة , اعتمدت على الورقة العلمية التي نشرت و هي حوالي 40 صفحة.

( سلسلة )

arxiv.org

( سلسلة )

arxiv.org

سأحاول أن تكون اللغة سهلة حتى لغير المطلعين على الذكاء الاصطناعي لتوضيح الفكرة و الإمكانيات و لماذا هذه المرة هناك شيء جديد و مختلف.

الGPT-3 باختصار هو مولّد لغوي , اختصاصه معالجة اللغات الطبيعية NLP , ابسط مثلا على الNLP هو تصنيف التغريدات , لو اخذنا مثلا 10 الاف تغريدة و صنفناها , هذي مدح و هذي ذم , فممكن توليد نموذج نعطيه اي تغريدة جديدة و هو يتنبأ و يقول إن كانت مدح او ذم !.

الgmail مثلا عنده مودل يعرف اذا البريد الإلكتروني حقيقي او مجرد spam. المترجمات , المدققات اللغوية , سيري و اليكسا و مثيلاتها و الchatbots ايضاً تعتمد على الـ NLP. قوقل لديها نموذج ضخم اسمه BERT لتحسين الاستعلام في محركها.

هناك Models كثيرة غير الGPT-3 تغذت بالاف او مئات الآلاف النصوص لكن هذا النموذج تحديداً عملاق , تغذى على 175 مليار مُدخل بحيث لا يمكن تشغيله على جهاز واحد و يحتاج عشرات الخوادم و هذا مافعلته شركة OpenAi طورته و ابقته لديها و اعطت API لاستخدامه.

تم تغذية النموذج بـ415 مليار من Common Crawl و هو ارشيف مجاني يحوي تقريباً كل ما ينشر في الانترنت حجم بياناته قبل سنتين كانت حوالي 220 تيرا بايت!. بالإضافة إلى الويكبيديا و ثلاث مصادر اخرى لاتقل حجم عن ويكيبيديا. نموذج BERT الخاص بقوقل كان له مصدرين فقط و يكيبيديا و مصدر اخر.

فكرة GPT-3 بسيطة فهو يعتمد على التنبؤ بالكلمة التالية ضمن سياق معين فمثلاً لو كتبت له "غزا نابليون مصر عام …. " سيكمل الجُملة هذا يسمى Zero-shot learning.

و لو اُعطي سؤال أو مُهمة "ترجم من الإنجليزية إلى الفرنسية"

ثم اعطيته مثال واحد لكلمة انجليزية و ترجمتها بالفرنسية تكفيه أنه يفهم السياق ولا يحتاج تدريب اكثر من ذلك

بحيث يصبح قادراً على ترجمة أي كلمة من الإنجليزية للفرنسية

و هذا النوع يسمى الOne-shot learning

ثم اعطيته مثال واحد لكلمة انجليزية و ترجمتها بالفرنسية تكفيه أنه يفهم السياق ولا يحتاج تدريب اكثر من ذلك

بحيث يصبح قادراً على ترجمة أي كلمة من الإنجليزية للفرنسية

و هذا النوع يسمى الOne-shot learning

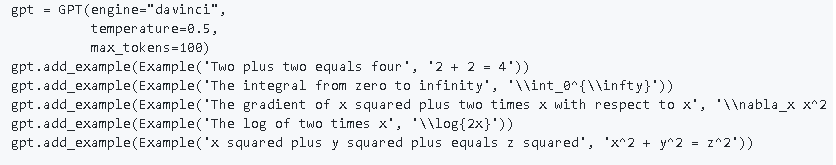

الطريقة الثالثة أن تعطيه مثلاً ثلاثة امثلة للسؤال و جوابه ثم تعطيه سؤال مشابه و يعطيك الإجابة و هو ما حصل في توليد بعض الأكواد البرمجية لreact او sql و هذا يسمى Few-shot learning

الموضوع إلى الآن قد يراه البعض عادي لكن لو سألت شخصاً سؤال مثل "من مخترع الراديو؟"

معلومة كهذه عادة نبحث عنها في كتاب او في قوقل , لكن الGPT-3 لا يبحث و ليس لديه بيانات جاهزة يقرأ منها و مع هذا يعطينا المعلومة! فكيف عرف ؟! .

معلومة كهذه عادة نبحث عنها في كتاب او في قوقل , لكن الGPT-3 لا يبحث و ليس لديه بيانات جاهزة يقرأ منها و مع هذا يعطينا المعلومة! فكيف عرف ؟! .

هذا شيء اشبه بالذاكرة البشرية التي لا تخزن المعلومات بل تحتفظ بأنماط التأثير الكهربائي ( كتوقيع خاص ) و التي تنقلته لنا الحواس و لذا ذاكرة الإنسان لا تمتليء.

مع أن النموذج لم يمر عليه سوى حوالي الشهر , إلا ان المبرمجين قاموا بتطوير wrappers للapi ستجد مكتبات لبايثون و سي شارب و جافا سكريبت للتعامل معه. فمثلاً هذه مكتبة لبايثون سهلة الاستخدام.

github.com

github.com

جاري تحميل الاقتراحات...