#ثريد |

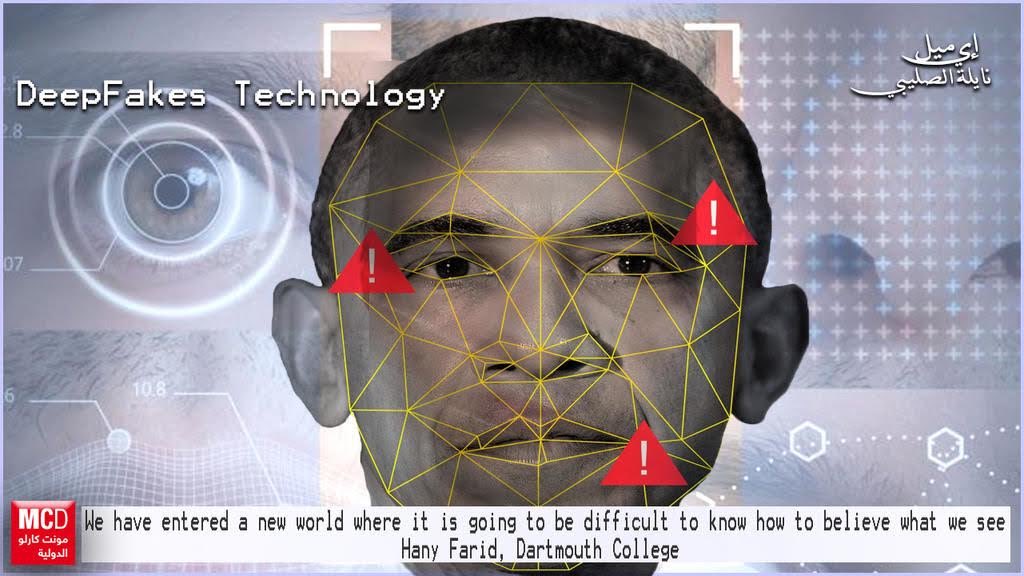

تقنية DeepFakes ؟

كل تقنيات #الذكاء_الاصطناعي

التي ظهرت في السنوات الأخيرة الماضية، لا تثير القلق والخوف بقدر ما تثيره تقنية الـ Deep Fake أو ما يعرف بالتزييف العميق!

تقنية DeepFakes ؟

كل تقنيات #الذكاء_الاصطناعي

التي ظهرت في السنوات الأخيرة الماضية، لا تثير القلق والخوف بقدر ما تثيره تقنية الـ Deep Fake أو ما يعرف بالتزييف العميق!

هناك استخدامات إيجابية لتقنية deepfake مثل صنع الأصوات الرقمية للأشخاص الذين فقدوا أصواتهم،

ومع ذلك، فإن احتمال استخدام هذه التقنية بطريقة مؤذية يثير قلقاً كبيراً، خاصة وأن هذه التقنية أصبحت أكثر دقة عما كانت عليه منذ ظهورها في العام 2017.

ومع ذلك، فإن احتمال استخدام هذه التقنية بطريقة مؤذية يثير قلقاً كبيراً، خاصة وأن هذه التقنية أصبحت أكثر دقة عما كانت عليه منذ ظهورها في العام 2017.

حاليًا هنالك عدد من التطبيقات على متجر Google Play، ومتاجر Apple App التي تتيح لك مبادلة وجهك بشخص آخر، حتى سناب شات لديها واحد تطبيق لمبادلة الوجوه مع بعض الفلاتر

يستخدم الكثير من الأشخاص هذه الفلاتر لإنشاء مقاطع فيديو مضحكة على الإنترنت، لكن لا شيء من هذه تبدو حقيقيةً مثل تلك التي تم إنشاؤها بواسطة Deepfakes، وهنا تظهر خطورة هذا الأمر.

فالأمر قد لا يقتصر على بعض الفيديوهات التشهيرية أو المسيئة، وإنما قد يصل لاختراق خصوصية المستخدمين بسبب صورهم المنتشرة على الإنترنت وشبكات التواصل الاجتماعي، مما يعني أن أي مقطع فيديو تراه قد لا يكون حقيقًا بل مزيفًا

بواسطة DeepFakes !

بواسطة DeepFakes !

يقترح بعض الخبراء أن زيادة الوعي سيكون خطوة أولى مهمة. حيث سيكون تثقيف الناس وتعريفهم بقدرات خوارزميات #الذكاء_الاصطناعي إجراءًا جيدًا لمنع الاستخدامات السيئة لبرامج مثل FakeApp التي لها تأثير واسع النطاق على الأقل في المدى القصير.

وهنا يبرز الحل المثالي وهو استخدام

#تقنية بلوك تشين #Blockchain

التي تُمكنك من تخزين بياناتك عبر الإنترنت دون الحاجة إلى خوادم مركزية. فمن خلال البلوك تشين يتم نسخ كل سجل على العديد من أجهزة الكمبيوتر وربطه بزوج من مفاتيح التشفير

#تقنية بلوك تشين #Blockchain

التي تُمكنك من تخزين بياناتك عبر الإنترنت دون الحاجة إلى خوادم مركزية. فمن خلال البلوك تشين يتم نسخ كل سجل على العديد من أجهزة الكمبيوتر وربطه بزوج من مفاتيح التشفير

أحدهما عام والآخر خاص، وسيكون صاحب المفتاح الخاص هو المالك الحقيقي للبيانات وليس أجهزة الكمبيوتر التي تخزنها.

- إمكانية الاستعانة بتقنية histogram of oriented Gardiants، ويرمز لها اختصارًا بـ HOG، ويتمثل دورها بإجراء مقارنات بين البيكسل الموجود في كل صورة مع البيكسل الموجود في الصور المحيطة استعدادًا لرسم منحنى يبدأ من الأقل ظلمة نحو الأكثر ظلمة.

- إجراء تدريب مشفر تلقائي بعد الإنتهاء من استخدام مستخرجات صور الوجوه.

- الانتقال إلى مرحلة الدمج، تستخدم الصورة المستخرجة والمعالجة من auto encoder ووضعها مكان الصورة الأصلية.

- الانتقال إلى مرحلة الدمج، تستخدم الصورة المستخرجة والمعالجة من auto encoder ووضعها مكان الصورة الأصلية.

- إعادة صنع الفيديو مجددًا بعد استخدام الصورة المعدلة.

- الخوارزمية تحتاج إلى شرح معقد طويل جدًا يصعب تطبيق خطواتها من قِبل أي شخص عادي.

- الخوارزمية تحتاج إلى شرح معقد طويل جدًا يصعب تطبيق خطواتها من قِبل أي شخص عادي.

ترتب على استخدام هذه التقنية الكثير من الأثار السلبية، ومنها:

- ازدياد رقعة الفوضى والتشويش نتيجة التزوير القائم على تقنيات الذكاء الاصطناعي.

- احتمالية تزوير رسائل البريد الإلكتروني والمحادثات النصية بالاعتماد على معالجة اللغات الطبيعية والخوارزميات.

- ازدياد رقعة الفوضى والتشويش نتيجة التزوير القائم على تقنيات الذكاء الاصطناعي.

- احتمالية تزوير رسائل البريد الإلكتروني والمحادثات النصية بالاعتماد على معالجة اللغات الطبيعية والخوارزميات.

- فقدان الثقة في كل ما يمكن مشاهدته نظرًا لتزوير الرسائل الصوتية بالاعتماد على خوارزميات #الذكاء_الاصطناعي .

- تدمير حياة الكثير من الأشخاص بالتسبب لهم بالفضائح الجنسية دون أي حق.

- تدمير حياة الكثير من الأشخاص بالتسبب لهم بالفضائح الجنسية دون أي حق.

جاري تحميل الاقتراحات...